Em um desdobramento alarmante para a privacidade digital, a OpenAI, desenvolvedora do onipresente ChatGPT, encontra-se em uma disputa legal contra uma ordem judicial que a força a reter absolutamente todos os registros de conversas de usuários. Isso inclui não apenas os chats que os usuários conscientemente optaram por apagar, mas também dados sensíveis de clientes corporativos que utilizam a API da empresa. A base para essa exigência draconiana? Alegações de organizações de notícias de que a OpenAI estaria destruindo evidências em processos de violação de direitos autorais.

Eles estarão de olho

A ordem de 13 de maio, proferida pela Juíza Ona Wang, é descrita pela OpenAI como nada menos que “precipitada” e “sem precedentes”, forjada a partir de “suspeitas infundadas” levantadas por veículos como o The New York Times. A OpenAI denuncia que a decisão foi imposta antes mesmo que a empresa tivesse a chance de apresentar sua defesa, em uma flagrante desconsideração pelo devido processo. A principal e revoltante consequência, segundo a empresa, é que essa ordem impede a OpenAI de “respeitar as decisões de privacidade de seus usuários”, desrespeitando a autonomia de centenas de milhões de pessoas que utilizam o ChatGPT em suas mais variadas formas.

Evidências Especulativas vs. Direitos Fundamentais

As organizações de notícias expressaram o temor, no mínimo especulativo, de que usuários do ChatGPT que burlam paywalls “possam ter maior probabilidade de ‘excluir todas as suas buscas’ para apagar seus rastros”. E, inacreditavelmente, a Juíza Wang parece ter acatado essa hipótese como base para uma medida tão invasiva. A juíza inferiu que, na ausência de uma ordem, a OpenAI continuaria a apagar o que ela considerou “provas” – uma conclusão tirada sem qualquer evidência concreta de má-fé por parte da OpenAI.

A OpenAI, por sua vez, refuta veementemente as acusações de destruição intencional de dados. A empresa insiste que não “destruiu” ou “apagou” dados em resposta a qualquer litígio, sugerindo que a ordem judicial parte de uma premissa fundamentalmente equivocada. É um absurdo que a OpenAI seja forçada a comprometer a privacidade de seus usuários com base em meras conjecturas e sem a apresentação de uma necessidade substancial para tal violação massiva de dados.

O caos que causa essa ordem

A ordem judicial, que permanece em vigor, força a OpenAI a “abandonar seu compromisso de permitir que os usuários controlem quando e como seus dados de conversa do ChatGPT são usados e se são retidos”. Isso representa uma completa subversão das políticas de privacidade que a empresa prometeu aos seus usuários. Antes dessa determinação, os usuários tinham o direito de excluir conversas, usar “chats temporários” que desapareciam, ou até mesmo apagar suas contas inteiras, confiando que seus dados seriam tratados com o devido respeito à sua privacidade. Agora, mesmo as opções mais básicas de privacidade são desconsideradas, e os dados de “temporary chats” e solicitações de API que deveriam ser excluídas são, por força da lei, preservadas. Para aplicativos que dependem da API da OpenAI, isso significa que suas próprias políticas de retenção de dados “simplesmente não podem ser honradas”, como prontamente alertado por especialistas e usuários nas redes sociais.

A indignação dos usuários

A reação dos usuários foi de pânico e indignação, e com razão. Plataformas como LinkedIn e X (antigo Twitter) foram inundadas com alertas sobre uma “séria quebra de contrato para todas as empresas que usam a OpenAI” e um “risco de segurança inaceitável”. É revoltante que milhões de pessoas, que usam o ChatGPT para fins que variam do trivial ao profundamente pessoal – como dados financeiros ou detalhes íntimos –, agora vejam sua confiança traída por uma medida judicial que prioriza especulações de direitos autorais sobre direitos fundamentais de privacidade. Muitos, em um ato de legítima autodefesa, já estão recomendando o uso de ferramentas alternativas como Mistral AI ou Google Gemini.

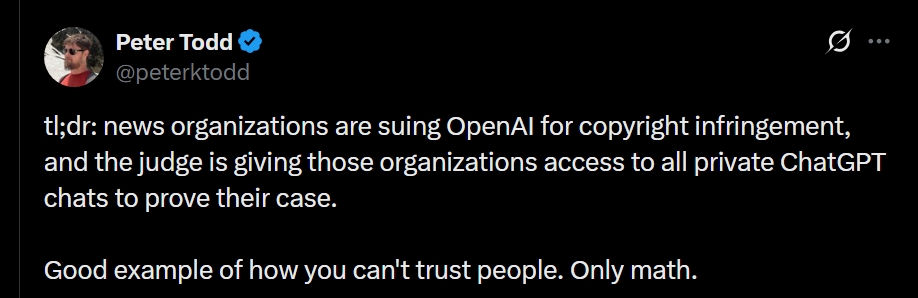

Essa indignação já havia sido alertada pelo ex-colaborador e desenvolvedor do Bitcoin Core, Peter Todd, em sua mensagem:

“Resumo: organizações de notícias estão processando a OpenAI por violação de direitos autorais, e o juiz está concedendo a essas organizações acesso a todas as conversas privadas do ChatGPT para que possam comprovar o caso. Bom exemplo de como não se pode confiar em pessoas. Só na matemática.“

E agora?

Ainda é incerto se a OpenAI conseguirá convencer a Juíza Wang a reconsiderar essa ordem invasiva. A juíza, ao justificar a amplitude da medida, apelou para a alegação de que “o volume de conversas excluídas é significativo”, e sugeriu que a OpenAI poderia ter anonimizado os logs, mas não o fez. Tal argumentação, diante da magnitude da invasão de privacidade, soa como uma justificativa insuficiente para o comprometimento de um direito tão fundamental.

Enquanto a batalha legal prossegue, com porta-vozes da OpenAI e da equipe jurídica do The New York Times recusando-se a comentar, o futuro da privacidade dos dados dos usuários do ChatGPT permanece em um limbo preocupante, um lembrete sombrio dos perigos de ceder direitos individuais em nome de preocupações corporativas.